Atualmente no Brasil é discutido o Projeto de Lei (PL 21/2020), sobre a regulamentação das big techs no uso dos algoritmos de IA, e entre um dos trechos do PL está a não discriminação por vieses fenótipos e raciais e reprodução de preconceitos como a xenofobia (Brasil, 2021). A Organização das Nações Unidas (ONU), em relatório de 2021, já alertava sobre como os algoritmos de IA podem reproduzir vieses preconceituosos e reverberar violências para pessoas e grupos historicamente vulneráveis.

Em levantamentos de estudos sobre a temática no campo nacional (Silva, 2020a; Silva 2020b) e internacional (Nobre, 2018), os(as) pesquisadores(as) denunciam o viés racista na programação dos algoritmos. Casos sobre episódios de racismo algorítmico tratam do embranquecimento de rostos negros por filtros em aplicativos como FaceAPP, discutidos em estudos do pesquisador negro Silva (2020b) e reforçado em reportagem como exemplificado na Figura 1.

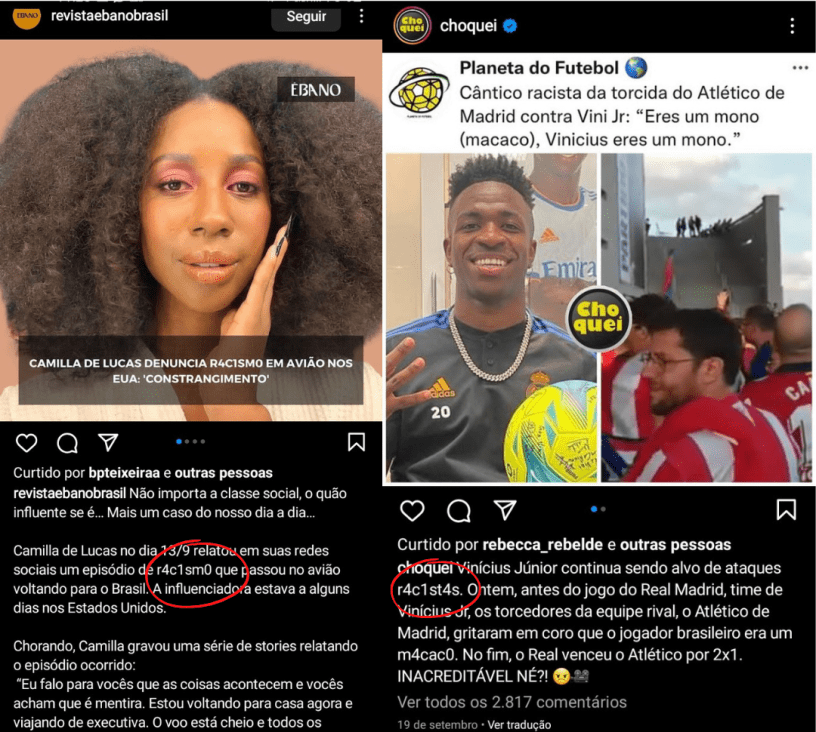

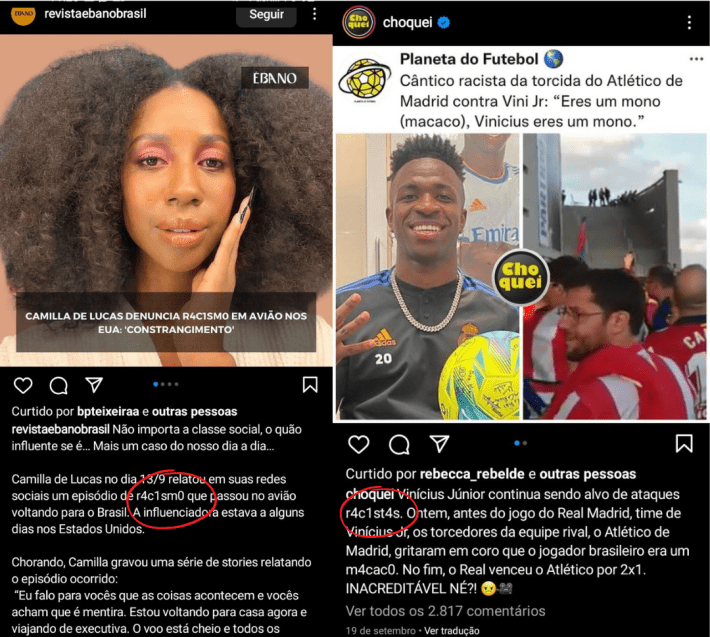

Este é apenas um dos comportamentos descritos como racista na lógica dos algoritmos. O racismo de dados é percebido na escrita quando expressões raciais são identificados por aplicativos como o Instagram como termos violentos (Sap et al, 2019). Os autores discutem como esse enviesamento impacta na queda de engajamento de conteúdos raciais que abordem em sua escrita termos como ‘Racismo’. Para combater essa lógica, páginas brasileiras no Instagram utilizam como estratégia misturar letras e números em termos raciais como ‘R4C1SM0’.

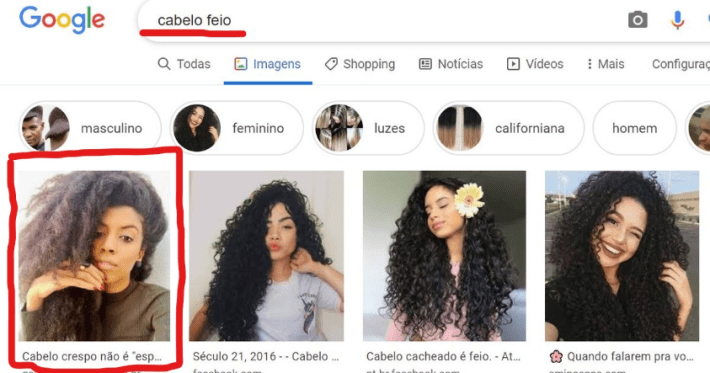

Outro comportamento racista fica evidenciado nos resultados fornecido por algoritmos de plataformas como o Google, onde termos pejorativos como ‘cabelo feio’ apresentam resultados de pessoas negras – como denunciado em reportagem de Pinheiro (2021).

Em vista disto, para compreender tais resultados é importante entender que algoritmos são fórmulas matemáticas criadas desde a antiguidade, visando a resolução de problemas e execução de tarefas. Com o advento da Quarta Revolução Industrial e Tecnológica, suas inovações possibilitaram o desenvolvimento de algoritmos de Inteligência Artificial (IA) nos Sistemas de Informação (SI) (Lévy, 1993). Os chamados algoritmos de segunda geração se desenvolvem a partir da ecologia cognitiva da aprendizagem de máquina (machine learning), que possibilitam a esses algoritmos coletar, armazenar em grandes bancos rastros digitais, reconhecer e cruzar padrões coletivos de dados junto a predileções individuais (Lévy, 1993; Zuboff, 2015).

Segundo Zuboff (2015), as inovações da IA nos SI de big techs como Google, Instagram, Facebook, Twitter, e etc, dentre outras corporações do Vale do Silício, passam a utilizar algoritmos de aprendizagem de máquina de forma massiva em dispositivos e plataformas como smartphones, redes sociais, aplicativos de mensagens e etc. Nesse sentido, entender a massificação e uso desses algoritmos está atrelado ao mercado que o alicerça, o big data é um modelo econômico que se constitui em inovações tecnológicas que objetificam a comercialização de dados sensíveis dos usuários na internet, em que as big techs compartilham e lucram por meio do capitalismo de vigilância (Zuboff, 2015).

Acerca disso, Kaufman & Santaella (2020) exemplificam o funcionamento desses algoritmos em mídias digitais como o Instagram: 1) Um perfil curte um rells sobre moda; 2) A curtida oferece dados de entrada para o algoritmo (input); 3) Com isso, a IA por meio da aprendizagem de máquina, aprende que o perfil tem interesse nesse nicho de conteúdos, perante seu rastro digital; 4) A IA realiza um cruzamento ou mineração no seu banco de dados coletivo, cruzando conteúdos sobre moda que mais geram engajamento e impacto na plataforma; 5) Os algoritmos apresentam nas indicações dos próximos rells resultados (outputs) de conteúdos sobre moda que tem maior chance de fazer seu usuário se interessar, com objetivo de que gaste mais tempo no Instagram (Kaufman & Santaella, 2020; Zuboff, 2015).

A partir da capacidade dos algoritmos de IA em aprender por meio dos dados dos humanos, Nobre (2018), em seu livro Algorithms of Oppression, discute como esse tipo de tecnologia está suscetível a vieses em sua programação por meio dos próprios rastros digitais dos usuários que carregam concepções preconceituosas como o racismo. O autor compreende o racismo como um sistema estrutural institucionalizado que atua em diferentes setores da sociedade, tendo como objetivo alocar pessoas negras na inferioridade e marginalidade, tal como trata Nascimento (2016).

Corroborando com isso, estudiosos do campo da programação como Mejías e Couldry (2019) discutem que o banco de dados dos algoritmos de IA reforçam uma estrutura racista e colonial. Logo, a interlocução do racismo estrutural transpõe-se no que o autor nomeia de colonialismo de dados, que alicerça práticas contemporâneas no uso das mídias sociais para reforçar o não lugar das pessoas negras na sociedade. Desta forma, as inovações tecnológicas renovam e reverberam dinâmicas psicossociais discriminatórias a comunidades historicamente vulnerabilizadas, contudo, agora de maneira mais camuflada na programação das mídias sociais.

No aspecto individual as afetações do racismo algorítmico para o trabalho de influenciadores(as) podem atuar na alta cobrança por produção constante de conteúdo para seus seguidores, necessitando o influenciador(a) estar sempre atento às telas para captar tendências de viralização (Borges, 2022). Segundo dados da Organização Mundial de Saúde (OMS), o uso excessivo de aparelhos tecnológicos pode gerar uma propensão a afetações negativas na saúde física e mental com prejuízos significativos em áreas como relações interpessoais, familiares, educacionais, ocupacionais entre outros campos da vida (WHO, 2018).

Já em levantamento do mercado de influência digital, os dados mostram que influenciadores(as) negros(as) no país tem menor remuneração em comparação com influenciadores(as) brancos(as) (Rocha et al., 2020). Logo, essa dinâmica psicossocial discriminatória se mantém no virtual , no qual o racismo algorítmico, de acordo com o autor, afeta o engajamento, compartilhamento e outras métricas de construção de capital social dos influenciadores(as) negros(as); prejudicando a remuneração final.

Em estudo recente, Ávila (2019) levanta questões sobre os fluxos migratórios contemporâneos de imigrantes negros(as) no Brasil. Na pesquisa, é discutida a capacidade que as mídias sociais têm de agregar e dispersar conteúdos e informações de diversas comunidades migratórias, como a haitiana. Nos relatos os migrantes dizem que a motivação por migrar está na busca por uma melhor qualidade de vida e oportunidades de emprego, e que muitos acompanharam conterrâneos que compartilhavam suas rotinas nas redes sociais (Ávila, 2019).

Em pesquisa similar de Lyra (2023), a autora analisa o papel dos influenciadores venezuelanos nos fluxos migratórios para o Brasil. Nos resultados os imigrantes mencionam que acompanhar os influenciadores foi importante na realização de processos burocráticos como emissão de documentos, planejamento de custo de vida e entendimento de características culturais. Assim, o local ocupado pelo imigrante influenciador(a) o(a) torna uma referência para a parcela da comunidade no país de origem que busca migrar, fazendo com que seus perfis tenham um capital social valorizado pelas métricas de seguidores, curtidas, visualizações e outras (Lyra, 2023).

No marco contemporâneo de uma sociedade midiatizada, o movimento das diásporas se reformula perante as TICs, com sua capacidade de visibilização de migrantes e de suas práticas culturais e psicossociais (ElHajji, 2011). Na perspectiva do autor, as TICs e suas plataformas possibilitam a grupos de imigrantes o resgate e troca de experiências e vivências que contribuem com a construção de identidades transnacionais e subjetivas, mediadas pela midiatização das redes sociais (ElHajji & Escudero, 2016).

Assim, partindo dos dados e referenciais teóricos problematizados, soa o alerta sobre como imigrantes negros(as) que atuam como influenciadores(as) digitais podem ser afetados pelo racismo que se reformula em dados e afeta questões psicossociais, laborais e de saúde mental. Há ainda uma lacuna nas pesquisas sobre compreender como imigrantes negros(as) que atuam como influenciadores(as) digitais podem ser afetados por essa nova forma de racismo por meio dos algorítmicos em interseccionalidades de origem nacional e preconceitos xenófobos.

Nesse sentido, são importantes pesquisas sobre tais fenômenos contemporâneos para orientar iniciativas governamentais para a regulação da IA no congresso brasileiro, visando a não reprodução de preconceitos históricos. Além de guiar políticas públicas para essa nova categoria de profissionais na reparação e equidade de oportunidades para grupos historicamente vulnerabilizados, como imigrantes negros(as).

Referências:

Ávila, O. C. (2019). Webdiáspora e a Decisão de Migrar: Relatos Haitianos no Brasil. Espaço Aberto, 9(1), 43-59. <https://dialnet.unirioja.es/servlet/articulo?codigo=7879930>.

Ávila, O. C. (2022). Autoapresentação, Performatividade e Testemunho na Internet: A Webdiáspora Deslocada para a Visibilidade do Self Migrante. Tese de Doutorado, UFRJ. <http://www.pos.eco.ufrj.br/site/teses_dissertacoes_interna.php?tease=23>.

American Psychiatric Association. (2014). DSM-5: Manual diagnóstico e estatístico de transtornos mentais. Artmed Editora.

Borges, C. A.(2022). O dano existencial no trabalho sem pausas dos influenciadores digitais. Editora Dialética, 2022.

Brasil. (2021). Senado vai analisar projeto que regulamenta uso da inteligência artificial. Agência Senado.<https://www12.senado.leg.br/noticias/materias/2021/10/02/senado-vai-analisar-projeto-que-regulamenta-uso-da-inteligencia-artificial#:~:text=Senado%20vai%20analisar%20projeto%20que%20regulamenta%20uso%20da%20intelig%C3%AAncia%20artificial,-Da%20Ag%C3%AAncia%20Senado&text=Ap%C3%B3s%20ser%20aprovado%20na%20C%C3%A2mara,2020)>.

ElHajji, M., & Escudero, C. (2016). Webdiáspora: Migrações, TICs e memória coletiva. Revista Observatório, 2(5), 334-363. <https://doi.org/10.20873/uft.2447-4266.2016v2n5p334>.

ElHajji, M. (2011). Mapas subjetivos de um mundo em movimento: migrações, mídia étnica e identidades transnacionais. Economia Política das Tecnologias da Informação e da Comunicação, 13(2). https://d1wqtxts1xzle7.cloudfront.net/62477100/2011_-_mapas_subjetivos_pronto20200325-21578-ewakws-with-cover-page-v2.pdf?Expires=1666291512&Signature=VNmpmCLyMDTkc-v4~hJOqYgfNAEaZlyOZKdjGor~66M9C8I6ZEviC6Y8JHGTvX36UbMz-jz9ZctopLNjSydKqSV2C2sz8ZRRnDwlNiFURaLliKnez3Zmb~0Y~M94olD1dDWODs~w3M6xwBqbjlxNYxf9oh6l~T1EbhnZALt50LXevyL9yTV3n6oTBrit66Suaz06UTc0aZURNkppL4OFFh~KfGxwOOTDQbhEw6QypJErfHejuz6seNyzA5ll-qB4ETzt5-HDrAfi07S2aERQiJuhHJ-rCvHkUuoeCiTRkYPT-6B9xNeLrXp~zO3euBA7jTldmUHAkgc8bLlPhr6Edg__&Key-Pair-Id=APKAJLOHF5GGSLRBV4ZA.

Kaufman, D., & Santaella, L. (2020). O papel dos algoritmos de inteligência artificial nas redes sociais. Revista Famecos, 27(20), 34-74. <https://doi.org/10.15448/1980-3729.2020.1.34074>.

Lévy, P. (1993). As Tecnologias da inteligência., Editora 34. <https://books.google.com.br/books?hl=pt-BR&lr=&id=BqB9h-W8AeUC&oi=fnd&pg=PA7&dq=L%C3%A9vy,+P.+(1993).+As+Tecnologias+da+intelig%C3%AAncia.+1,++S%C3%A3o+Paulo,++Editora+34,+200+p.&ots=JySz-I7kmz&sig=TaZfYk0qJhPunkap6XjkreLf6UQ#v=onepage&q&f=false>.

Lyra, J. A. (2023). Ser migrante, tornar-se influencer: visibilidade, inspiração e estratégias de pertencimento da migração venezuelana no Brasil [Tese Mestrado, Universidade Federal de Pernambuco – UFPE]. Biblioteca Digital de Teses da UFPE. <https://sigaa.ufpe.br/sigaa/public/programa/defesas.jsf?lc=pt_BR&id=883>.

Moraes, Y. (2020). Digital Influencers denunciam racismo algorítmico do Instagram. Negrê. <https://negre.com.br/digital-influencers-denunciam-racismo-algoritmico-do-instagram/?msclkid=a43ec693bc0911ec8a5879543157a7fc>.

Mejías, U., & Couldry, N. (2019). Colonialismo de datos: repensando la relación de los datos masivos con el sujeto contemporáneo. Virtualis, 10(18), 78-97. <https://doi.org/10.2123/virtualis.v10i18.289>.

Nascimento, A. (2016). O genocídio do negro brasileiro: processo de um racismo mascarado. Editora Perspectiva SA. <https://books.google.com.br/books?hl=pt-BR&lr=&id=8KFBDgAAQBAJ&oi=fnd&pg=PT4&dq=NASCIMENTO,+A.+2016.+O+genoc%C3%ADdio+do+negro+brasileiro:+processo+de+um+racismo+mascarado.+Editora+Perspectiva+SA,+201+p.+&ots=IB9XiJfWoM&sig=2smE5UKS7Ee7eLHQudv20JMnirE#v=onepage&q=NASCIMENTO%2C%20A.%202016.%20O%20genoc%C3%ADdio%20do%20negro%20brasileiro%3A%20processo%20de%20um%20racismo%20mascarado.%20Editora%20Perspectiva%20SA%2C%20201%20p.&f=fals>.

Noble, S. U. (2018). Algorithms of oppression. In Algorithms of Oppression. New York University Press. <https://doi.org/10.18574/nyu/9781479833641.001.0001>.

Organização das Nações Unidas. (2021). Urgent action needed over artificial intelligence risks to human rights. <https://news.un.org/en/story/2021/09/1099972>.

O’neil, C. (2016). Weapons of math destruction: How big data increases inequality and threatens democracy. Crown Publishing Group (NY).<https://www.amazon.com.br/Weapons-Math-Destruction-Increases-Inequality/dp/0553418815>.

Rocha, C. J., Porto, L. V., & Abaurre, H. E. (2020). Discriminação algorítmica no trabalho digital. Revista de Direitos Humanos e Desenvolvimentos Social, 1(20), 1-21.<https://doi.org/10.24220/2675-9160v1e2020a5201>.

Silva, T. (2020a). Racismo Algorítmico em Plataformas Digitais: microagressões e discriminação em código. In: T. Silva (org), Comunidades, algoritmos e ativismos digitais: olhares afrodiaspóricos. Literarua. <https://www.researchgate.net/profile/Fernanda-Carrera-2/publication/341767578_Racismo_e_sexismo_em_bancos_de_imagens_digitais_analise_de_resultados_de_busca_e_atribuicao_de_relevancia_na_dimensao_financeiraprofissional/links/5ed2db3e458515294521df0e/Racismo-e-sexismo-em-bancos-de-imagens-digitais-analise-de-resultados-de-busca-e-atribuicao-de-relevancia-na-dimensao-financeira-profissional.pdf#page=121>.

Silva, T. (2020b). Visão computacional e racismo algorítmico: branquitude e opacidade no aprendizado de máquina. Revista Da Associação Brasileira De Pesquisadores/As Negros/As (ABPN), 12(31), 428-448. <https://pdfs.semanticscholar.org/25c7/29b537061509f16a92fd9611911c5cfd8734.pdf>

Sap, M., Card, D., Gabriel, S., Choi, Y., & Smith, N. A. (2019). The risk of racial bias in hate speech detection. Proceedings of the 57th annual meeting of the association for computational linguistics, Florença, 2019. Anais, 1:1668-1678. <https://homes.cs.washington.edu/~msap/pdfs/sap2019risk.pdf>.

World Health Organization. (2018). Are our smart phones affecting our mental health?.<https://www.who.int/china/news/detail/28-03-2018-are-our-smart-phones-affecting-our-mental-health->.

Zuboff, S. (2015). Big other: surveillance capitalism and the prospects of an information civilization. Journal of information technology, 30(1), 75-89. <https://link.springer.com/article/10.1057/jit.2015.5>.